クラウドネイティブ、クラウドネイティブ。それは至る所で耳にしますが、その理由は明確です – インフラストラクチャの構築と管理の方法は時代と共に変化してきました。しかし、これらの流行語の渦中においても、非常に実践的な質問が依然として残っています:ワークロードをコンテナで実行すべきか、仮想マシン(VM)で実行すべきか?

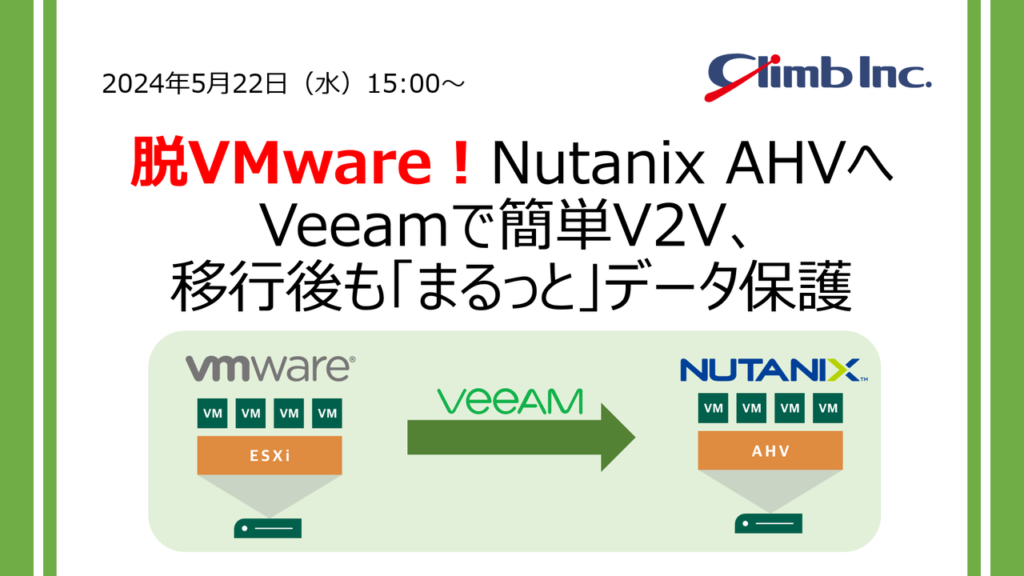

続きを読む- Web3月18日(水) ランサムウェア対策も安心!クラウド&仮想環境の災害対策なら「HPE Zerto」におまかせ!

- セミナー4月8日(水) 【オンライン】Veeamハンズオンセミナー 基本編

- セミナー情報一覧

- イベント3月7日(土) 【東京】JAWS DAYS 2026に出展します

- イベント情報一覧

-

カテゴリーで絞る

- Microsoft365 (1)

- セキュリティ (39)

- バックアップ (46)

- VMware (231)

- vSphere (62)

- vCenter (21)

- vCloud Director (2)

- Hyper-V (48)

- その他製品・ツール (24)

- ディザスタ・リカバリ (44)

- FAQ (9)

- トラブル (22)

- 機能 (45)

- 設定 (40)

- AWS (39)

- Azure (23)

- Windows (4)

- クラウド・仮想インフラ (138)

- セミナー動画 (2)

関連リンク

- CloudBerry Backup :クラウドへの安全で確実なバックアップ

- HyTrust(ハイトラスト):仮想とクラウドのセキュリティ

- Kasten K10 Platform: Kubernetes環境のバックアップとモビリティ

- N2WS Backup & Recovery:AWSデータ保護ツール

- StarWind: ソフトウェア共有ストレージ

- Veeam B&R :VMware/Hyper-Vバックアップ/レプリケーションソフト

- Veeam One: VMware・Hyper-Vモニター&レポートソフト

- Webセミナー録画集

- Zerto: クラウド・ハイパバイザ間でのレプリケーション

- クライムのオフィシャルTwitter

- 仮想化対応ツール技術ブログ

- 総合FAQサイト

よく読まれている記事

- vSphere CLI コマンド(vmware-cmd)【仮想化プラットホーム VMware vSphere】 - 315,972 views

- Linux仮想マシンでVMware Toolsではなくopen-vm-toolsを使う - 176,517 views

- VMwareのスナップショット作成・削除処理の仕組み - 169,468 views

- ... - 118,741 views

- VMware/Hyper-Vの仮想ディスクを相互変換可能なフリーソフト【StarWind V2V Convert... - 113,966 views

- ... - 104,933 views

- VMware toolsのインストール方法【Linux編】【仮想化プラットホーム VMware vSpher... - 101,553 views

-

新着記事

- スケーラブル・バックアップ・ターゲット・アーキテクチャ

- Amazon S3とは? S3ストレージの仕組み、ストレージクラス、および利用ケース

- Boxの問題点と、Google Workspaceへの移行は簡単か?移行の関する問題点

- AWS Backupの料金体系について:利用するバックアップストレージ容量、復元するデータ、および有効化するオプション機能に応じて料金が発生

- Kubernetesバックアップの重要性

- スケールアップ対スケールアウト:ITインフラの拡張戦略

- Veritas Backup Exec vs. Veeam Backup & Replication の比較

- ExaGrid とWasabi Hot Strageのエアギャップ機能の比較

- Microsoft 365のバックアップ自動化:M365バックアップコストを30%削減する方法

- 高可用性(HA): アーキテクチャ、原則、および実用の使用例

Top30タグリスト

ランサムウェア対策 (7)クラウドバックアップ (5)Immutable (4)ハイブリッドクラウド (4)microsoft365 (3)高可用性 (2)EBSスナップショット (2)GCP (2)VDI (2)Zerto (1)Starwind (1)Azure Backup (1)Azure SQL Database (1)Azure Storage (1)Entrust (1)BYOK (1)XFS Freeze (1)XFS (1)Backup (1)AWS S3 Storage Lens (1)AWS Security Hub (1)AWS License Manager (1)AWS Audit Manager (1)RaaS (1)N2WS Backup and Recovery (1)AWS Storage Gateway (1)クラウド・ストレージ・プロバイダー (1)Veeam Backup for AWS (1)AFA (1)ロギング (1)-

メールマガジン登録

- 海外”クラウドコンピューティング”最新技術を中心に、注目コンテンツを紹介

バックナンバー [climbクラウド・ナウ]

- 海外”クラウドコンピューティング”最新技術を中心に、注目コンテンツを紹介

RSSフィードを取得する

RSSフィードを取得する

クライム主催セミナー

出展・参加イベント

最近「Sovereign European Cloud API(SECA)」のリリースが発表されました。

最近「Sovereign European Cloud API(SECA)」のリリースが発表されました。 あなたは、クラウドへの移行を検討しているか、すでに移行している最中でしょうか?クラウド移行は新しい概念ではありませんし、多くの企業が移行を進めていますが、移行を決断する前に知っておくべきポイントがいくつかあります。データベースをクラウドに移行する作業は、計画立案、データの整理、テスト実行などに多くの時間を要しますが、適切に行われない場合、メリットよりもデメリットの方が大きくなる可能性があります。以下の5つのステップは、クラウド移行のプロセスをガイドし、移行時に直面する主な障害をカバーします。適切に実施すれば、コスト削減、ユーザアクセスの一元化、パフォーマンスの向上、その他のクラウドのメリットを享受できるでしょう。

あなたは、クラウドへの移行を検討しているか、すでに移行している最中でしょうか?クラウド移行は新しい概念ではありませんし、多くの企業が移行を進めていますが、移行を決断する前に知っておくべきポイントがいくつかあります。データベースをクラウドに移行する作業は、計画立案、データの整理、テスト実行などに多くの時間を要しますが、適切に行われない場合、メリットよりもデメリットの方が大きくなる可能性があります。以下の5つのステップは、クラウド移行のプロセスをガイドし、移行時に直面する主な障害をカバーします。適切に実施すれば、コスト削減、ユーザアクセスの一元化、パフォーマンスの向上、その他のクラウドのメリットを享受できるでしょう。